Dviejų konkuruojančių neuroninių tinklų sistema išmoko generuoti beveik sekundę video, remdamiesi vieninteliu statišku fotokadru.

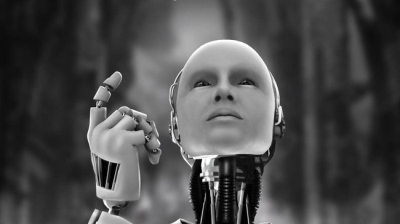

„Bet kuris realiame pasaulyje veikiantis robotas privalo gebėti bent jau bendrais bruožais numatyti ateitį, – sako Carl Vondrick iš MIT. – Pavyzdžiui, jei nusprendėte prisėsti, jis turi pristumti jums kėdę, o ne patraukti.“ Tokia užduotis ir paskatino Vondricką su kolegomis užsiimti sistemos, generuojančios kelis tolesnius kadrus iš vienos pradinės nuotraukos, kūrimą.

DI mokėsi iš maždaug 2 milijonų laisvai prieinamų „Flickr“ vaizdo klipų. Autoriai pažymi, kad buvo atrenkami nepažymėti įrašai, kad įrašai nepasakinėtų DI. Jis buvo realizuotas konkuruojančių tinklų (Adversarial Networks) architektūros pagrindu: Vienas neuroninis tinklas generuoja pratęsimo variantus, o antrasis vertina jų tikėtinumą. Abu jie treniruojasi vienas prieš kitą: pirmasis stengiasi apgauti antrąjį, o antrasis – ieško menkiausių apgaulės ženklų.

Sistema kol kas veikia tik su mažos raiškos vaizdais ir generuoja 32 kadrus – mažiau nei sekundę. Tačiau jie teisingai vysto pirminiame kadre vykstantį veiksmą: lėktuvas skrenda tinkama trajektorija, medžiai siūbuoja vėjyje ir t. t. Vondrickas pripažįsta, kad jų sistema daug ko negali – visų pirma, jai trūksta žinių apie realųjį pasaulį. Kita vertus, jis pažymi, kad 2 milijonai vaizdo klipų atitinka maždaug 2 metus nenutrūkstamo žiūrėjimo. Kaip dviejų metų vaikas, jų DI aplinkoje gaudosi ne taip jau ir blogai.

„The New Scientist“ duomenimis, sistemos kūrėjai rengiasi ją pristatyti gruodžio pradžioje Ispanijoje vyksiančioje konferencijoje.