Amsterdamo Vrije universiteto tyrėjas Alex‘as de Vries‘as parašė straipsnį „Didėjantis dirbtinio intelekto energetinis pėdsakas“, kuriame nagrinėjamas dirbtinio intelekto sistemų poveikis aplinkai. De Vries‘as pažymi, kad didelių kalbos modelių mokymo etapas dažnai laikomas daugiausiai energijos reikalaujančiu etapu, todėl dirbtinio intelekto srityje daugiausia dėmesio skiriama tvarumo tyrimams.

Po to mokymo modeliai diegiami į gamybinę aplinką ir pradedamas išvadų darymo etapas. „ChatGPT“ atveju tai yra tiesioginių atsakymų į naudotojų užklausas generavimas. Tyrimų, susijusių su išvadų darymo etapu, atlikta nedaug, tačiau De Vries‘as mano, kad yra požymių, jog šis laikotarpis gali gerokai padidinti dirbtinio intelekto modelio sąnaudas.

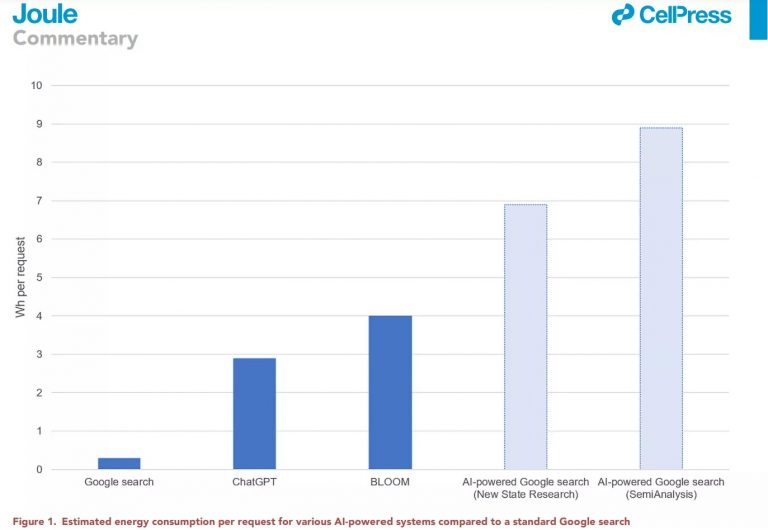

Tyrimų bendrovės „SemiAnalysis“ duomenimis, „OpenAI“ prireikė 3 617 NVIDIA „HGX A100“ serverių, kuriuose iš viso buvo 28 936 grafikos procesoriai, kad būtų palaikoma „ChatGPT“, o tai reiškia, kad per dieną reikėjo 564 MWh energijos. Palyginimui, GPT-3 mokymo etape buvo sunaudota maždaug 1 287 MWh, taigi išvadų darymo etape energijos poreikis buvo gerokai didesnis.

Bendrovės „SemiAnalysis“ skaičiavimais, į „ChatGPT“ panašią dirbtinio intelekto funkciją įdiegus į kiekvieną „Google“ paiešką, prireiktų 512 821 A100 HGX serverio, iš viso 4 102 568 grafinių procesorių. Vienam serveriui reikia 6,5 kW galios, todėl per dieną būtų sunaudojama 80 GWh elektros energijos, o per metus – 29,2 TWh, t. y. maždaug tiek pat, kiek kasmet sunaudoja Airija.

Mažai tikėtina, kad toks scenarijus artimiausiu metu įvyks, visų pirma todėl, kad NVIDIA neturi gamybinių pajėgumų tiekti daugiau nei pusę milijono HGX serverių, o jų įsigijimas „Google“ kainuotų 100 mlrd. dolerių.

Dokumente pažymima, kad DI rinkos lyderė NVIDIA 2023 m. turėtų pristatyti 100 000 savo dirbtinio intelekto serverių. Jei šie serveriai veiktų visu pajėgumu, jų bendras elektros energijos poreikis siektų 650-1020 MW, o per metus jie sunaudotų iki 5,7-8,9 TWh elektros energijos. Tai beveik nereikšmingas kiekis, palyginti su duomenų centrų metiniu suvartojimu (205 TWh). Tačiau iki 2027 m. NVIDIA gali pristatyti 1,5 mln. dirbtinio intelekto serverių vienetų, todėl jų metinis energijos suvartojimas padidės iki 85,4-134,0 TWh. Tai maždaug tiek pat, kiek suvartoja tokios šalys kaip Argentina, Nyderlandai ar Švedija.